Tempered Adversarial Networks

13 Jun 2018

TL;DR

- GANの学習は安定しない

- GeneratorとDiscriminatorのバランスを調整するのが難しい

- Mode Collapse

- 普通のGANはfixされたデータ分布に生成分布を近づける

- この手法ではデータ分布を生成分布に近づけるようにして安定化を図った

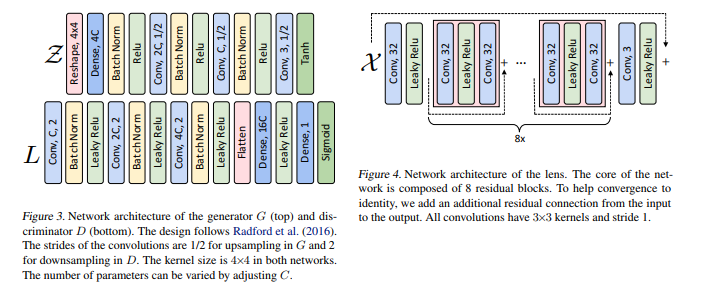

- データ分布を生成分布に近づけるために Lens Networkを用いる

- この枠組みは,DCGAN・LSGAN・WGANなどObjectiveにかかわらず有効

Tempered Adversarial Networks

GANのもともとのObjectiveは以下

データ分布$X$は学習中ずっと固定されたままである.それに対して,生成分布は学習中常に変化している.

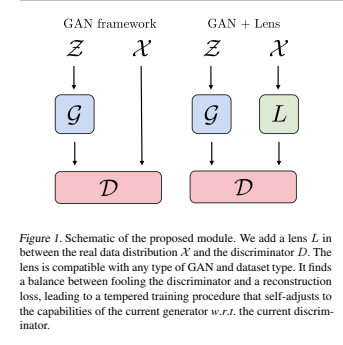

この非対称を解決するためにLens Network ($L$)を用いる.

Lens を $x\sim{X}$ をDiscriminatorに入力する直前に適用する.

Lens の最適化には$L^A_L$と$L^R_L$の2つのLossを用いる. $L^A_L$は敵対的誤差であり,$L^R_L$は再構成誤差である.

再構成誤差はLensがすべて0や写像するなどの自明解への収束を防ぐためである.

レンズは再構成とGANの元々のObjectiveのバランスを自動的に取らせている.

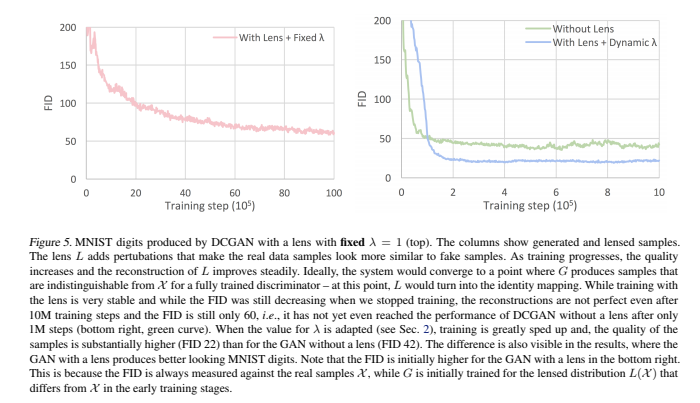

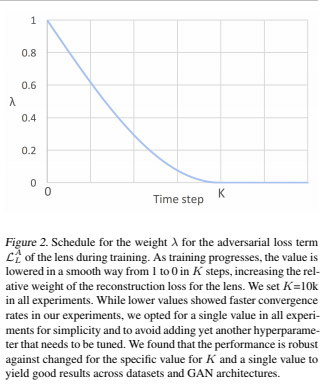

パラメータ$\lambda$は,学習が進むにつれて減少するように設計している.

$\lambda=0$になると,Lensは取り払ってしまう.

論文内では$K=10^5$で固定している.

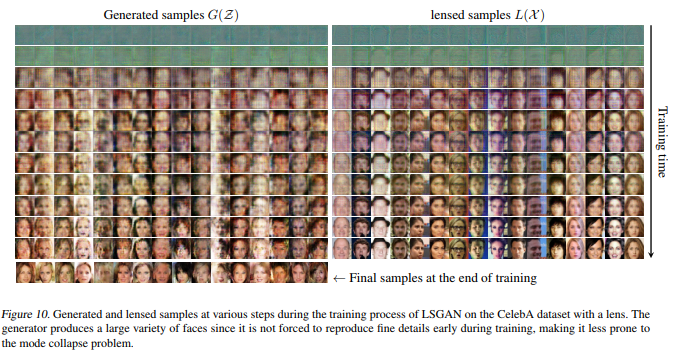

Lensは単射(1対1対応の写像)である必要はない.

だからLensによって同じデータポイントへ写像されることがあるが,これは分布の複雑さを緩和してくれる.

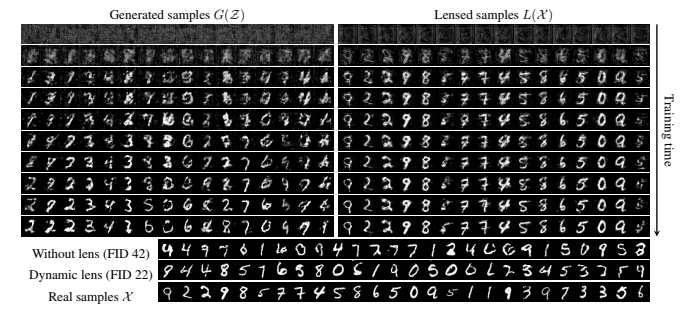

このようなLensをDiscriminatorの前につけることで,データ分布を生成分布に近づける.

それにより学習が安定する.

以前から,ガウスノイズなどを$x\sim{X}$に付加するテクニックは存在したが,手動でノイズの強さを減衰させていた.

この手法では,Lensがその調節すらも学習している.